服务器限制百度蜘蛛(屏蔽百度蜘蛛)

- 服务器

- 2022-12-19 07:03:29

- 30

本篇文章给大家谈谈服务器限制百度蜘蛛,以及屏蔽百度蜘蛛对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

- 1、网站上的文章被删除了一部分,百度抓取频次有异常,这样的情况该怎么处理?

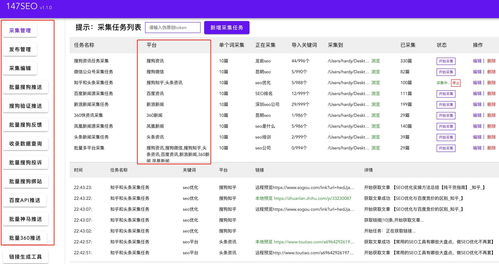

- 2、如何限制百度等蜘蛛的抓取频率

- 3、百度服务器拒绝百度蜘蛛访问?

- 4、百度蜘蛛抓取异常的原因?

- 5、百度网站抓取异常的原因有哪些?有什么影响和解决方法?松友饮

- 6、如何阻止百度baidu爬虫和谷歌蜘蛛抓取网站内容

网站上的文章被删除了一部分,百度抓取频次有异常,这样的情况该怎么处理?

首先要看你网站是不是新站,如果是新站,继续推广优化;如果是老站,删除的少也没什么影响,花点时间提高内容质量,坚持SEO优化常态工作,不要急于求成,使用一些黑帽等不良手法,见效虽快,但不长久;故不必担心,大胆去尝试,总结出属于自己的推广方法,你会发现并不是那么难,保持空杯心,你也慢慢会成为这方面的大神,希望能帮到你,谢谢!

如何限制百度等蜘蛛的抓取频率

百度也是遵循 robots抓取规则的,如果不想限制 想要百度收录又想不对服务器造成过高负载的话,现在百度有站长平台 你可以在那里提交压力反馈 限制百度抓取频率。

百度服务器拒绝百度蜘蛛访问?

你好,百度熊掌资源号里面的爬取你可以多试几次,出现403错误也可以检查下权限设置。

403:403错误,是一种在网站访问过程中,常见的错误提示。403错误,表示资源不可用。服务器理解客户的请求,但拒绝处理它,通常由于服务器上文件或目录的权限设置导致的WEB访问错误。

多抓几次看,如果还是这样,建议更换服务器。

百度蜘蛛抓取异常的原因?

有一些网页,内容优质,用户也可以正常访问,但是Baiduspider却无法正常访问并抓取,造成搜索结果覆盖率缺失,对百度搜索引擎对站点都是一种损失,百度把这种情况叫“抓取异常”。对于大量内容无法正常抓取的网站,百度搜索引擎会认为网站存在用户体验上的缺陷,并降低对网站的评价,在抓取、索引、排序上都会受到一定程度的负面影响,最终影响到网站从百度获取的流量。

下面向站长介绍一些常见的抓取异常原因:

1,服务器连接异常

服务器连接异常会有两种情况:一种是站点不稳定,Baiduspider尝试连接您网站的服务器时出现暂时无法连接的情况;一种是Baiduspider一直无法连接上您网站的服务器。

造成服务器连接异常的原因通常是您的网站服务器过大,超负荷运转。也有可能是您的网站运行不正常,请检查网站的web服务器(如apache、iis)是否安装且正常运行,并使用浏览器检查主要页面能否正常访问。您的网站和主机还可能阻止了Baiduspider的访问,您需要检查网站和主机的防火墙。

2,网络运营商异常:网络运营商分电信和联通两种,Baiduspider通过电信或网通无法访问您的网站。如果出现这种情况,您需要与网络服务运营商进行联系,或者购买拥有双线服务的空间或者购买cdn服务。

3,DNS异常:当Baiduspider无法解析您网站的IP时,会出现DNS异常。可能是您的网站IP地址错误,或者域名服务商把Baiduspider封禁。请使用WHOIS或者host查询自己网站IP地址是否正确且可解析,如果不正确或无法解析,请与域名注册商联系,更新您的IP地址。

4,IP封禁:IP封禁为:限制网络的出口IP地址,禁止该IP段的使用者进行内容访问,在这里特指封禁了BaiduspiderIP。当您的网站不希望Baiduspider访问时,才需要该设置,如果您希望Baiduspider访问您的网站,请检查相关设置中是否误添加了BaiduspiderIP。也有可能是您网站所在的空间服务商把百度IP进行了封禁,这时您需要联系服务商更改设置。

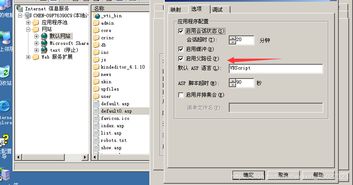

5,UA封禁:UA即为用户代理(User-Agent),服务器通过UA识别访问者的身份。当网站针对指定UA的访问,返回异常页面(如403,500)或跳转到其他页面的情况,即为UA封禁。当您的网站不希望Baiduspider访问时,才需要该设置,如果您希望Baiduspider访问您的网站,useragent相关的设置中是否有Baiduspider UA,并及时修改。

6,死链:页面已经无效,无法对用户提供任何有价值信息的页面就是死链接,包括协议死链和内容死链两种形式:

协议死链:页面的TCP协议状态/HTTP协议状态明确表示的死链,常见的如404、403、503状态等。

内容死链:服务器返回状态是正常的,但内容已经变更为不存在、已删除或需要权限等与原内容无关的信息页面。

对于死链,我们建议站点使用协议死链,并通过百度站长平台--死链工具向百度提交,以便百度更快地发现死链,减少死链对用户以及搜索引擎造成的负面影响。

7,异常跳转:将网络请求重新指向其他位置即为跳转。异常跳转指的是以下几种情况:

1)当前该页面为无效页面(内容已删除、死链等),直接跳转到前一目录或者首页,百度建议站长将该无效页面的入口超链接删除掉

2)跳转到出错或者无效页面

注意:对于长时间跳转到其他域名的情况,如网站更换域名,百度建议使用301跳转协议进行设置。

8,其他异常:

1)针对百度refer的异常:网页针对来自百度的refer返回不同于正常内容的行为。

2)针对百度ua的异常:网页对百度UA返回不同于页面原内容的行为。

3)JS跳转异常:网页加载了百度无法识别的JS跳转代码,使得用户通过搜索结果进入页面后发生了跳转的情况。

4)压力过大引起的偶然封禁:百度会根据站点的规模、访问量等信息,自动设定一个合理的抓取压力。但是在异常情况下,如压力控制失常时,服务器会根据自身负荷进行保护性的偶然封禁。这种情况下,请在返回码中返回503(其含义是“Service Unavailable”),这样Baiduspider会过段时间再来尝试抓取这个链接,如果网站已空闲,则会被成功抓取

百度网站抓取异常的原因有哪些?有什么影响和解决方法?松友饮

所谓抓取异常,就是指搜索引擎蜘蛛无法抓取网站页面,百度抓取异常的原原因主要分两大类,一是网站异常,二是链接异常.

网站异常原因

1、dns异常

当百度蜘蛛(Baiduspider)无法解析您网站的IP时,会出现DNS异常。可能是您的网站IP地址错误,或者域名服务商把Baiduspider封禁了。

可以用WHOIS或者host查询自己网站IP地址是否正确而且可以解析,如果不正确或无法解析,与域名注册商联系,更新网站IP地址。

2、连接超时

抓取请求连接超时,可能原因是:服务器过载或网络不稳定。

3、抓取超时

抓取请求连接建立后,下载页面速度过慢,导致超时。可能原因服务器过载,带宽不足。

4、连接错误

无法连接或者连接建立后对方服务器拒绝。

5、服务器异常

服务器连接异常最大的可能是网站服务器过大,超负荷运转,通过检查浏览器输入你的域名是否正常访问。服务器异常会导致蜘蛛无法连接网站服务器,导致出现抓取失败。

6、域名过期

域名过期网站肯定不能访问,域名解析就会失效了。如果存在这类情况,你可以与你域名注册商联系解决,看是否被抢注,还是可以续费回来。

7、网络运营商异常

电信和联通这两种都是属于网络运营商,蜘蛛无法访问的网站。

如果是因为电信或联通网络运营商出现问题,与网络服务运营商联系或者购买CDN服务。

8、robots.txt文件设置问题

robots.txt的功效主要是一些不重要的文件屏蔽掉告诉搜索引擎这些些页面可以不抓取,但也可能会存在把重要的页面也给屏蔽了,可以检查下robots文件设置。

9、死链接因素

原本正常的链接后来失效了就是死链接,死链接发送请求时,服务器返回404错误页面。死链的处理方案可以通过百度站长平台提交死链文件。

链接异常原因

1、访问被拒绝

爬虫发起抓取,httpcode返回码是403。

2、找不到页面

爬虫发起抓取,httpcode返回码是404。

3、服务器错误

爬虫发起抓取,httpcode返回码是5XX

4、其他错误

爬虫发起抓取,httpcode返回码是4XX,不包括403和404。

希望对您有帮助!

如何阻止百度baidu爬虫和谷歌蜘蛛抓取网站内容

如果不希望百度或 Google抓取网站内容,就需要在服务器的根目录中放入一个 robots.txt 文件,其内容如下:

User-Agent: *

Disallow: /

这是大部份网络漫游器都会遵守的标准协议,加入这些协议后,它们将不会再漫游您的网络服务器或目录。

Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。

实例分析:淘宝网的 Robots.txt文件

User-agent: Baiduspider

Disallow: /

User-agent: baiduspider

Disallow: /

很显然淘宝不允许百度的机器人访问其网站下其所有的目录。

网站robots的情况,可以使用百度站长工具进行查询。

关于服务器限制百度蜘蛛和屏蔽百度蜘蛛的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

本文由admin于2022-12-19发表在靑年PHP官网,如有疑问,请联系我们。

本文链接:https://qnphp.com/post/47954.html