zblog禁止搜索(zblog搜索插件)

- ZBLOG

- 2023-10-24 06:25:06

- 6

zblog如何禁止列表翻页

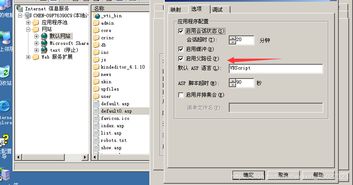

当域名变更或其它原因需要手动配置BLOG程序,参照此法:请先将c_custom.asp文件中的 ZC_BLOG_HOST 更改为已分配的IP或域名。格式一定要是http://yourblogurl/,前面要加 http:// ,后面要加上 / 。

首先登录Z-Blog后台管理界面,进入文章管理页面,找到要清零浏览量的文章。其次在文章列表中,找到对应的文章,点击编辑,进入文章编辑页面后,在右侧的选项中找到“浏览量”字段。

如果上面的步骤不可以,你可以尝试将zblog文件夹删除后,重新复制一个文件夹过来,一定要重新设定一遍zblog的写权限(包括子文件夹),然后方能正常使用。如何确认是真的数据库连接有问题。

换回原始默认的模板看看,要是也不正常,那是不是数据库出了什么问题。

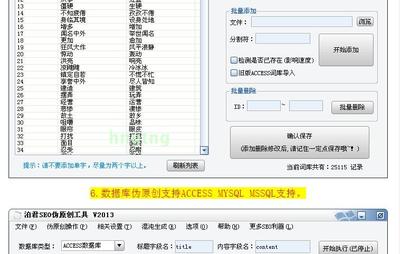

正文头尾或列表头尾添加!--重复特征代码-- 第一种防采集方法:下面我详细说一下这三种方法的实际应用:如果全加上,绝对可以有效的防采集,单独加一种就可以让采集者头疼。完全可以对付通用的CMS采集程序。

ZBLOG博客被挂马了怎么办?

人工检测,打开你的网站、博客,点击右键查看源文件,根据网页挂马的种类也可以查看是否中了木马;使用McAfee SiteAdvisor安全浏览网页的插件。发现木马可以通过以下方法进行清理。

扫描挂马的目录 扫描后将挂马文件删除,挂马文件会篡改页面内容,如果是生成文件则需要进行重新生成,如果是静态非生成文件,则需要把备份文件还原回去,如果没有备份文件我们则需要进行代码重新编辑删除被挂马篡改的部分内容。

简单的说,网页挂马 指的是把一个木马程序上传到一个网站,然后用木马生成器生一个网马,再上到空间里面!再加代码,使得木马在打开网页时运行!被挂马后,当然只能通过查杀手段把他删除了。

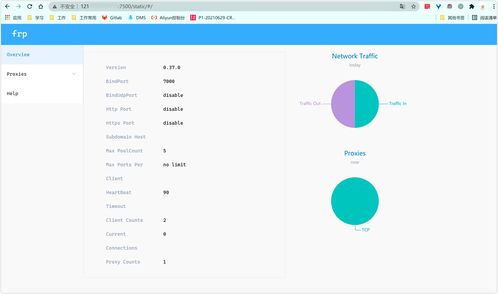

本地搭建的ZBLOG的标签页,搜索页和留言页面都进不了。打不开

1、网络设置的问题 这种原因比较多出现在需要手动指定IP、网关、DNS 服务器 联网方式下,及使用代理服务器上网的。仔细检查计算机的网络设置。

2、电脑被病毒感染了,导致网页打不开。一般导致这种情况是,你当下在运行一个或多个带病毒的软件或者文件。解决办法:方法一:点击360安全卫士领航版右下角更多一栏。在全部工具中找到人工服务一栏。

3、网站问题:网页所属网站正在维修或出现故障,无法正常显示;那就隔天再浏览。这个问题可通过非同一线路的其它正常电脑或使用流量上网的手机尝试浏览该网页以进行判断。

关于ZBLOG的优化

1、Z-Blog里面有三个插件是做搜索引擎优化(SEO)必不可少。Google站点地图 Ping中心和引用通告发送器 标题搜索引擎优化 Z-Blog 默认模板里面是没有keywords,description等meta标签的。有很多的SEO文章说着两个都要加进去。

2、网站内容更新方面 由于是博客,所以这个小站点的内容更新就只能是站长一个人在做。既然是一个人,所以我们在内容更新方面就会很有限度。

3、对SEO比较友好的程序像织梦CMS、wordpress、discuz、phpwind、zblog、phpcms、帝国CMS、ecshop等开源程序都是不错的。结合自身网站需要的功能和规模进行程序的选择,然后就到第三步选择域名和虚拟主机。

什么是常用的高端seo黑帽技术

1、博客作弊BLOG是一种交互性很强的工具。这几年,博客的兴起,成为了黑帽子SEO一个新的制造链接的福地。BLOG群发作弊:在国内常见的一些BLOG程序如:wordpress、 ZBLOG、PJBLOG、Bo-blog。

2、众所周知,SEO有白帽SEO和黑帽SEO之分,白帽SEO一直是我们的代言人。一般所说的“黑帽”,是指一切利用欺骗或可疑手段对网站进行优化,可以称之为黑帽SEO。下面华信环球来讲讲一些常用的SEO黑冒技术。(1)购买了老域名。

3、SEO黑帽是一种违反规定的优化技术,如果不是特殊的网站,正规的网站不建议采用黑帽技术,一般黑帽技术主要包含: 大众化的黑帽技术 博客作弊 BLOG,是一种交互性很强的工具。这几年,博客的兴起,成为了黑帽子SEO一个新的制造链接的福地。

4、笼统的说,所有使用作弊手段或可疑手段的,都可以称为黑帽SEO。比如说垃圾链接,隐藏网页,桥页,关键词堆砌等等。隐藏文字-利用CSS和JQuery效果做出的站。

5、虽然说很多黑帽SEO手法谈不上不道德,但搜索引擎肯定是痛恨黑帽的,因为黑帽它降低了搜索结果相关性和用户体验,动了搜索引擎的饭碗,属于必须严厉打击的范围。所以做黑帽被惩罚是正常的,甚至可以说,长远来看,是必然的。

6、那么到底什么样的技术算是黑帽技术呢? 下面商丘网络分享一些常见的黑帽SEO技术: 跳转页 一个跳转页常见的例子是创建搜索引擎,这可能会是没有意义的用户页面专为网站管理员。

请问zblog的robots.txt这么写正确么?

1、在 robots.txt 文件中,如果有多条- User-agent 记录说明有多个 robot 会受到 robots.txt 的限制,对该文件来说,至少要有一条 User-agent 记录。

2、robotx.txt是一种用于限制搜索引擎爬虫访问网站的文件。通常,网站管理员可以将不希望搜索引擎访问的内容,包括网站目录下的文件、HTML文件、CSS文件和JavaScript文件,添加到robotx.txt文件中。

3、robots.txt的写法是做seo的人员必须知道的(什么是robots.txt),但该如何写,禁止哪些、允许哪些,这就要我们自己设定了。

4、robots.txt是一个协议,而不是一个命令。robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

本文由admin于2023-10-24发表在靑年PHP官网,如有疑问,请联系我们。

本文链接:https://qnphp.com/post/243726.html